История развития искусственного интеллекта и его пришествия в биологию

15 декабря 2023

История развития искусственного интеллекта и его пришествия в биологию

- 4430

- 2

- 21

Путь от первых искусственных нейросетей до ChatGPT был довольно тернистым — и он не был бы пройден без появления языка Python, экспериментов в области распознавания изображений, успешных матчей с человеком по логическим играм и интереса со стороны техгигантов.

Рисунок в оригинальном разрешении.

иллюстрация Анастасии Самоукиной

-

Автор

-

Редакторы

-

Рецензенты

-

Иллюстратор

Искусственный интеллект занимает в современной биологии важное место — с его помощью можно предсказать строение белка, изучить структуру гена или даже написать научную статью. (Кстати — и прочитать тоже можно, чтобы попросить алгоритм извлечь из нее нужные факты.) В первой статье спецпроекта «Искусственный интеллект в биологии» мы попытаемся проследить, с чего всё начиналось и как искусственный интеллект пришел в биологию — или, наоборот, вышел из нее. Мы изучим основные вехи истории машинного обучения и обсудим их с российскими и зарубежными экспертами.

Искусственный интеллект в биологии

Развитие искусственного интеллекта в последнее десятилетие столь стремительно, что любые новости о нем устаревают вскоре после публикации. ИИ уже вышел за свои традиционные рамки (область информационных технологий) и вошел в другие сферы — например, научные исследования. В нашем спецпроекте мы хотим рассказать о достижениях ИИ в области современной (то есть молекулярной) биологии.

Партнер спецпроекта — научно-исследовательский Институт искусственного интеллекта AIRI: автономная некоммерческая организация, объединяющая ученых и инженеров данных. Миссия AIRI — создание универсальных систем ИИ, решающих задачи реального мира. AIRI активно развивает партнерства между академическим сообществом, промышленностью и образовательными организациями с целью поиска возможностей применения ИИ для решения сложных научных, социальных и экономических задач. Институт проводит профильные конференции и мероприятия, включая самую крупную в РФ летнюю школу по искусственному интеллекту для студентов, аспирантов и молодых исследователей «Лето с AIRI».

ИИ: начало

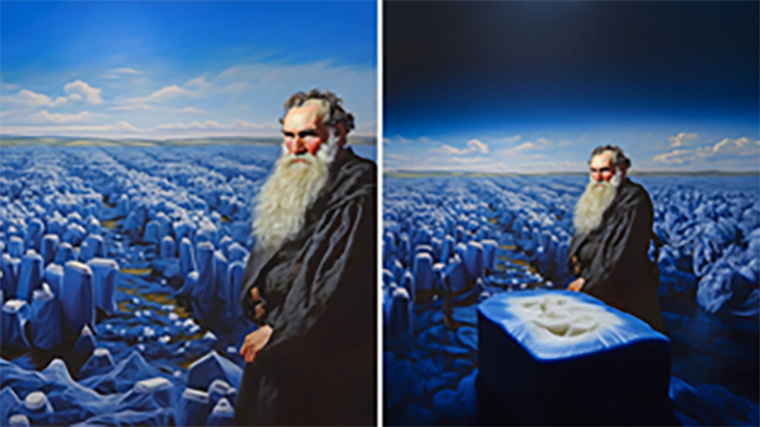

Отметить конкретный момент времени, до которого искусственного интеллекта (ИИ) не было, а потом он взял и появился, нельзя (но тем не менее, мы нарисовали таймлайн — см. рис. 1). Всё дело — в самом определении ИИ. Так называют технологии, способные выполнять задачи, традиционно требующие творческих или аналитических способностей человеческого интеллекта — поэтому граница между «ИИ» и «не-ИИ» довольно размыта. С большой натяжкой ИИ можно назвать даже автоматы, первые варианты которых появились более 200 лет назад — но это было совершенно не то, что подразумевается под ИИ сейчас. Сегодня про ИИ говорят и пишут всюду: в научно-популярных медиа, в глянцевых журналах, в изданиях для бизнесменов. О нем говорят не только ученые и программисты, но и политики, и даже обычные пользователи всё больше погружаются в этот мир. И, так как биологию эта волна популярности ИИ тоже не обошла стороной, «Биомолекула» начинает Спецпроект про об искусственном интеллекте и его применениях в биологии. В этой вводной статье мы постараемся нащупать истоки ИИ в современном смысле и разобраться, как его история была связана с биологией.

Рисунок 1. Таймлайн развития искусственного интеллекта. Здесь мы постарались изобразить основные вехи и отследить моменты времени, когда эта область менялась коренным образом и переходила на новый уровень .

Упомянутая на картинке компания Meta признана экстремистской организацией. Деятельность запрещена на территории РФ.

иллюстрация Анастасии Самоукиной

Основы теории ИИ — приблизительно в том виде, в каком мы его сейчас знаем, — заложил британский математик Алан Тьюринг (рис. 2). Крайне разносторонний человек (см. врезку далее), он приложил руку (то есть, скорее, голову) к решению многих задач прикладной математики и информатики [1]. В частности, он внес решающий вклад в расшифровку кода «Энигмы» — шифровальной машины германских нацистов — в годы Второй мировой войны. Занимался Тьюринг и математической биологией — в статье «Химические основы морфогенеза» [2] он предложил математическую модель развивающегося эмбриона и математически описал формирование сложных паттернов в его структуре (например, пятен на коже или шкуре). Эта статья в дальнейшем стала основой реакционно-диффузионных моделей, а специалисты по биологии развития смогли экспериментально подтвердить формирование паттернов Тьюринга (рис. 3) при развитии эмбрионов животных.

Рисунок 2. Алан Тьюринг в 1936 году во время учебы в Принстонском университете.

Но больше всего Тьюринг известен своей статьей «Вычислительные машины и разум», вышедшей в 1950 году в журнале Mind [7]. Именно в ней он предложил знаменитый тест Тьюринга, который вначале назвал игрой в имитацию (это оригинальное наименование стало названием фильма про Тьюринга). Идея теста состоит в том, чтобы сторонний наблюдатель задавал человеку и машине (которую бы мы сейчас назвали чатботом) вопросы посредством текстовых сообщений и пытался угадать, кто ему отвечает (рис. 4). Разумная машина, по мнению Тьюринга — это та, которая сможет обмануть наблюдателя, полностью изобразив человека.

Рисунок 4. Тест Тьюринга. Сидящий перед компьютером эксперт переписывается в чате с двумя другими участниками — вторым человеком и роботом. По мнению Алана Тьюринга, настоящим искусственным интеллектом станет робот, которого эксперт не сможет отличить от человека.

иллюстрация Анастасии Самоукиной

Из зарубежной научной периодики этот тест довольно быстро перекочевал даже в знакомую всем советскую книгу «Приключения Электроника», где его проводил профессор Гель Иванович Громов (используя своего ученика Александра Сергеевича Светловидова как «эксперта», который и должен был различить человека и машину):

„Какой же задать вопрос?“ — мучительно думал Светловидов. Он спросил самое простое:

— Что вы любите больше всего?

Ответы были простодушны и откровенны.

Икс:

— Кинофильмы.

Игрек:

— Люблю конфеты.

„Кто же хитрит? — возмутился Светловидов. — Смотрит ли машина кино? Нет. А как насчет конфет? Неужели я поглупел? И всё же — спокойствие. Надо разобраться детальнее“

Забегая вперед, отмечу, что подход Тьюринга стал в дальнейшем теоретической основой так называемого сильного искусственного интеллекта — разработки машин и программ, способных полностью имитировать человека и вести себя как человек (или превзойти его). Примером сильного ИИ, кстати, является тот самый Электроник из лаборатории Громова — а если взять роботов из произведений Азимова, их уже можно назвать AGI (что, впрочем, совершенно одно и то же). Но даже в наши дни они остаются научно-фантастическими персонажами. Пока даже неясно, могут ли быть созданы такие машины — поэтому весь ИИ, который сейчас используется в практических целях, является слабым искусственным интеллектом. Ему, в отличие от сильного, не нужно имитировать человека — а только освободить его от решения конкретной задачи. Например, написания этого текста.

|

|

|

| Серг Масис — ведущий аналитик данных компании Syngenta, автор бестселлера «Интерпретируемое машинное обучение на Python» и планируемой к выпуску книги DIY AI. Его сферой интересов является принятие решений на основе данных, ответственный ИИ, поведенческая экономика и увеличение доступности ИИ. | Мария Кадукова — PhD (Университет Гренобль-Альпы), исследователь в области машинного обучения в фармацевтической компании. Специализируется на алгоритмах для докинга малых молекул. | Ольга Кардымон — руководитель группы биоинформатики AIRI, биолог, биоинформатик, клинический интерпретатор геномных данных. Изучает применение языковых моделей для работы с последовательностями ДНК и белков. |

Спустя шесть лет после публикации статьи Тьюринга прошел Дартмутский семинар — двухмесячная конференция в Дартмутском колледже, ставшая первой по проблеме ИИ. Одним из ключевых выводов семинара стало смещение теоретического фокуса с имитации на обучение: основным требованием к искусственному интеллекту стало умение не имитировать, а обучаться (требования стали «слабее»). Но и после семинара искусственный интеллект оставался уделом теоретиков и казался чем-то оторванным от практических задач. Назвать временную точку, когда он наконец пришел в нашу жизнь, затруднительно, но определенные вехи выделить всё-таки можно. Серг Масис, специалист по анализу данных компании Syngenta и автор книги «Интерпретируемое машинное обучение на Python», считает поворотным моментом победу свёрточной нейросети AlexNet в конкурсе распознавания изображений ImageNet в 2012 году. В этом конкурсе проверялось умение нейросети классифицировать объекты по 20 000 категорий, включая, например, «клубнику» или «воздушный шар».

Если бы мне нужно было выбрать временную точку [когда начался современный этап развития ИИ], я выбрал бы технологический прорыв AlexNet, породивший ожидания и надежды на глубокое обучение и машинное обучение вообще. Именно тогда деньги и интерес инвесторов рекой потекли в ИИ.

Нейронные сети: эволюция компьютерного мозга

Здесь следует отметить, что AlexNet был не первым в своем классе — история разработки искусственных нейронных сетей началась, когда Алан Тьюринг еще только работал над расшифровкой «Энигмы», а его статьи, известные нынче всему миру, еще не были выпущены. В 1943 году Уоррен Маккалох и Уолтер Питтс публикуют статью «Логическое исчисление идей, относящихся к нервной активности» в журнале Bulletin of Mathematical Biology [8]. В этой работе они ввели само понятие искусственной нейронной сети и предложили модель искусственного нейрона — виртуальной клетки, работающей по принципу «всё или ничего» [9] (как и настоящий нейрон) и возбуждающейся при превышении порога входящих стимулов. Эта работа носила чисто биологический характер — авторы моделировали нейрон только для изучения физиологии живого мозга, без цели использовать эту модель в вычислениях. В 1949 году выходит книга Дональда Хебба «Организация поведения», которая, опять же, описывает работу нейронов мозга. Впоследствии станет ясно, что ряд изложенных в ней идей составляет основы обучения настоящих нейронных сетей. Например, Хебб отметил, что при активном взаимодействии двух нейронов связь между ними укрепляется — математики бы сказали, что увеличивается ее вес. Правда, Хебб еще не использовал термин «вес», прочно вошедший в современную науку об ИИ, но это утверждение попало в историю как правило Хебба и легло в основу группы методов обучения без учителя, называемой обучением по Хеббу [10].

Таким образом получается, что история применения нейросетей для построения ИИ началась именно с моделирования биологических процессов. Перефразируя известный анекдот про конец света, можно сказать, что ИИ не пришел в биологию — он из нее вышел. И самые первые архитектуры нейронных сетей были «подсмотрены» у природы — они копировали обработку информации теми или иными центрами мозга. Такие нейросети называют биологически мотивированными (англ. bio-inspired).

Такой стала первая нейросеть, или перцептрон, созданный нейробиологом Фрэнком Розенблатом в 1950-х гг. Фактически это было электронное устройство, моделирующее процесс человеческого восприятия. Его нейроны были аппаратными и представляли собой блоки электромеханических ячеек памяти. Такая нейросеть была линейным классификатором и к 1960 году могла распознавать некоторые буквы английского алфавита. Так что это время можно считать началом использования нейросетей для оптического распознавания текста.

Любопытно, что в ранних работах по нейросетям предлагалось реализовать нейросетевую память на основе нейронных ловушек — структур, реально существующих в головном мозге и играющих важную роль в сохранении воспоминаний [10]. В такой архитектуре нейроны соединены в замкнутый контур, по которому возбуждение может «бегать» теоретически бесконечно. Эта биологически мотивированная структура так и не была реализована по сей день — или, по крайней мере, не нашла своего применения в технологии ИИ.

Зато в одной из самых старых и одновременно самых «ходовых» архитектур нейронных сетей нашли воплощение другие структуры мозга — зрительные центры коры. Зрительная кора расположена в затылочной части больших полушарий и получает на вход информацию от латерального коленчатого тела — по сути дела, мощного выроста таламуса, играющего роль передаточного реле для информации, приходящей от сетчатки глаз по зрительному нерву. Если нейроны латерального коленчатого тела представляют собой просто живую «карту» сетчатки, осуществляющую лишь самую простую обработку сигнала и его передачу дальше, то в зрительной коре картой сетчатки является лишь самый первый слой нейронов — все остальные интегрируют сигналы от предыдущих слоев, в итоге формируя целостное восприятие объекта у нас перед глазами.

В 1960-х гг. нейроученые Дэвид Хьюбел и Торстен Визель начали детально изучать архитектуру этих слоев и передачу информации между ними, используя введение радиоактивных изотопов в сетчатку подопытных животных и регистрацию потенциала действия нейронов микроэлектродами [11]. Начала вырисовываться картина зон («слоев» обработки информации), на которые разбита зрительная кора, и их функций. По нынешним представлениям, их семь, и каждой соответствует свой уровень обработки изображения (рис. 5):

- V1: локальные признаки на изображении;

- V2: локальные признаки + стереоэффект;

- V3: цвет, текстуры, сегментация, группировка объектов;

- V4: геометрические фигуры и модуляция посредством внимания;

- V5: движения объектов, очертания которых выделены в зоне V4;

- V6: обобщение данных о всей картинке;

- V7: распознавание сложных объектов, в том числе лиц.

Рисунок 5. Зоны зрительной коры и распознаваемые ими объекты. Эти зоны можно одновременно рассматривать как слои нейронной сети зрительной коры — просто анатомически слои расположены не друг на друге, а рядом друг с другом (в коре нельзя поместить один слой кортикальных колонок на другой).

иллюстрация Анастасии Самоукиной

В 1981 году Хьюбел и Визель получили за свои исследования Нобелевскую премию, а годом раньше, в 1980-м, Кунихико Фукусима создает первый компьютер, моделирующий работу зрительных центров головного мозга — Neocognitron. Использовался он, можно сказать, по прямому назначению — для распознавания рукописных символов.

В Neocognitron уже были воплощены основные принципы работы зрительного центра: по первому слою, отображающему картинку, передвигалось виртуальное «окно», в котором выделялись локальные признаки. Эти признаки передавались на второй слой, с которым операция повторялась (видео 1). Такая модель требовала математической операции свёртки, давшей начало всему классу свёрточных нейронных сетей, появившихся в современном виде в работах группы Яна ЛеКуна в конце 1980-х гг.

Видео 1. Визуализация принципа распознавания символов символов (на примере буквы А) свёрточной нейросетью.

Оказалось, что такая компьютерная модель зрительного центра пригодна не только для изображений, но и для любых массивов, в которых можно выделить несколько главных осей и «каналов», описывающих свойства элементов массива (в изображении это горизонтальная и вертикальная ось и цветовые каналы RGB/HSB/CMYK). Проще говоря, свёрточной нейросети неважно, подана ей на вход последовательность интенсивностей пикселей по каналам RGB или последовательность интенсивностей звука с правым и левым стереоканалами. Свёрточные нейросети оказались универсальной архитектурой.

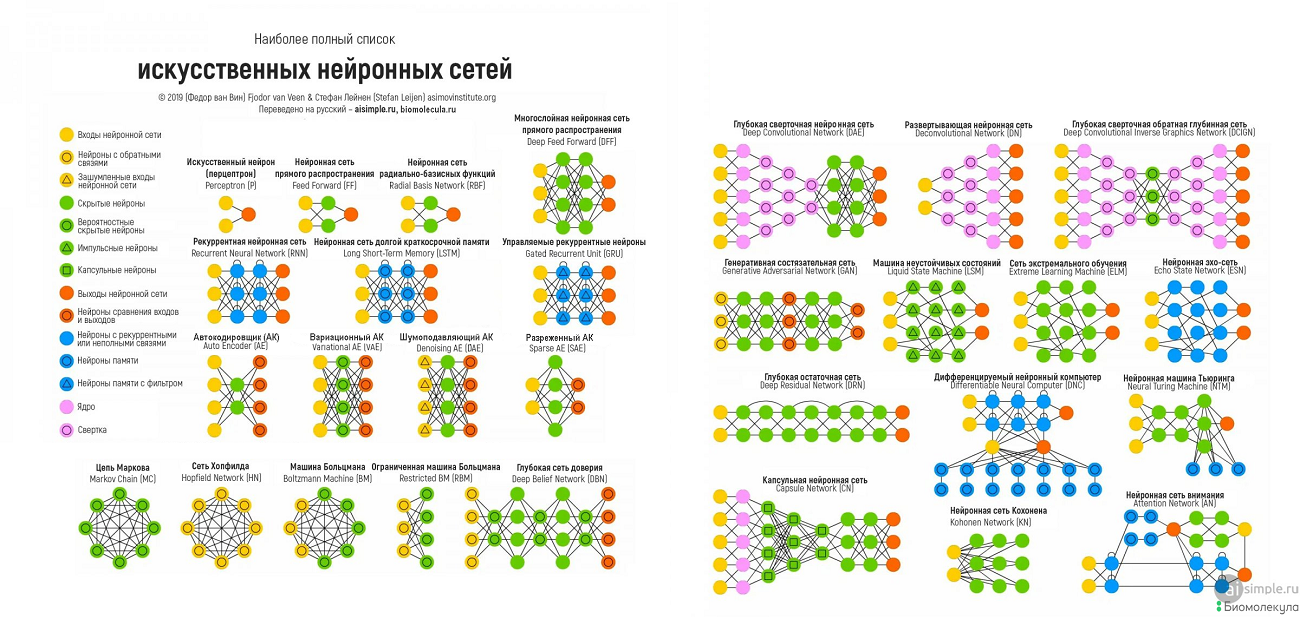

Интереснее всего, что исторически свёрточные нейронные сети оказались практически последней архитектурой, «списанной» с человеческого мозга. В «постсвёрточную» эру нейросети зажили уже самостоятельной жизнью — накопленного в научном сообществе математического аппарата и опыта построения нейронных сетей оказалось достаточно, чтобы моделировать нейронные структуры, отсутствующие в человеческом мозге. «Существует множество экзотических нейронных сетей, таких как сети радиально-базисных функций, сеть с эхо-состояниями, машины неустойчивых состояний и капсульные нейронные сети, которые сильно отличаются от механизмов работы человеческого мозга. Честно говоря, я думаю, что большинство нейросетей, за исключением стандартных свёрточных и некоторых рекуррентных, слишком мало похожи на мозг, чтобы назвать их биологически мотивированными. Фактически, если вы посмотрите на эту старую диаграмму нейронных сетей (рис. 6), вы увидите, что бóльшая часть из них лишена биологической мотивации, и нейросети в течение последних шести лет становились всё более экзотическими», — объясняет Серг Масис.

Рисунок 6. Диаграмма современных архитектур нейронных сетей.

Fjodor van Veen/Asimov Institute, переведено на русский Школой искусственного интеллекта

Помимо перечисленных вариантов, не являются биологически мотивированными и трансформеры — архитектуры нейронных сетей, активно используемые для обработки естественного языка в самые последние годы и предложенные разработчиками из Google Brain в 2017 году (видео 2) [12]. В настоящее время трансформеры — «пламенный мотор» таких известных сервисов, как ChatGPT и общеупотребительные онлайн-переводчики Google Translate и «Яндекс.Переводчик» .

Оба упомянутых сервиса широко критикуются переводческим сообществом за неточный и искаженный перевод. Сами переводчики, как и журналисты, для профессиональных целей предпочитают использовать DeepL, дающий более качественный перевод, сравнимый с человеческим. И интересно, что он построен как раз не на трансформере, а на обсуждавшихся ранее свёрточных нейронных сетях. Так что трансформер — не единственно возможная архитектура нейросети для обработки естественного языка, и его использование еще не предопределяет успеха.

Видео 2. Объяснение, почему трансформеры так хороши для обработки естественного языка и как они работают. Видео на английском языке — но даже не владеющие им могут его смотреть благодаря переводу субтитров встроенными средствами YouTube или звука с помощью «Яндекс.Браузера» — то есть, по сути, благодаря трансформерам!

Чтобы эффективно обрабатывать слова и предложения, трансформер включает в себя многочисленные кодирующие и декодирующие слои — аналог таких структур в мозге неизвестен. В 2023 году ученые всё-таки попытались построить трансформер из живых клеток и пришли к выводу, что одними нейронами тут не обойтись, в схему придется включать астроциты — глиальные клетки. С учетом того, что астроциты в живом мозге служат лишь метаболической поддержкой, а не «вычислительными» клетками, этот пример хорошо демонстрирует, насколько экзотичны могут быть современные нейросети по отношению к живому мозгу.

Правда, трансформеры, если разобраться, тоже не ушли от биологической мотивации совсем уж далеко: отличительной их чертой (наряду с рекуррентными нейросетями) является использование механизмов внимания — технического решения, позволяющего нейросети, подобно человеческому мозгу, «концентрироваться» на предположительно наиболее важных компонентах данных. Несмотря на то, что мы уже довольно много знаем о механизмах внимания в человеческом мозге [11], механизмы внимания в нейросетях не копируют их и разрабатываются «с нуля». Но невозможно отрицать, что механизмы внимания как концепция являются биологически мотивированными [10].

Классические методы: не будь таким наивным, Байес!

Одними нейросетями мир искусственного интеллекта не ограничивается. Как я уже писал выше, сейчас от искусственного интеллекта ожидают прежде всего способности обучаться — то есть давать реалистичные предсказания на основе имеющихся данных (называемых обучающей выборкой или обучающим набором данных). Для этого ИИ совсем не обязательно думать, как человеческий мозг — достаточно воспользоваться статистическими методами, которые относятся к так называемому классическому машинному обучению. Термин «машинное обучение» часто используется как синоним ИИ, но подчеркивает, что машине не обязательно думать как человек, хотя и обязательно учиться. Этого можно добиться гораздо более простыми методами, чем создание нейросети — но и здесь есть биологически мотивированные подходы, которые могут улучшить точность предсказаний.

Самые простые методы классического машинного обучения — регрессионные модели и наивный байесовский классификатор. В первом случае модель аппроксимирует зависимость одного признака от других с помощью заранее определенной формулы, параметры которой подбираются во время обучения на основе известных данных. Ничего творческого или в «сильном» смысле интеллектуального здесь нет. Но, так как при этом машина приобретает способность делать предсказания на основе выборки данных, можно сказать, что она учится. Это настолько «слабый» ИИ, что «слабее» и представить невозможно — но он работает и активно применяется! Любой, кто хоть раз строил «линию тренда» в Excel, по сути, работал с линейной регрессией. Ее большим достоинством является простота интерпретации.

Во втором случае всё чуть сложнее. Машине дается выборка из объектов разных категорий, каждый из которых обладает набором признаков. По ней она рассчитывает вероятность наличия того или иного признака при условии принадлежности объекта к той или иной категории — как частоту соответствующего признака в категории. На этой стадии всё просто, никакого обучения еще не нужно.

Непосредственно для работы классификатора используется теорема Байеса, которая позволяет «поменять местами» условие и событие в формуле условной вероятности. Она активно применяется и вне ИИ — например, ею пользуются генетики-консультанты для расчета риска наследственного заболевания у потомства, если уже есть данные по предыдущим детям. На вход модели подается объект с набором признаков, и программа рассчитывает по теореме Байеса условную вероятность принадлежности к той или иной категории при наличии заданных признаков, подставляя в формулу условные вероятности, полученные при обучении. По сути дела, здесь даже нет намека на какое-то моделирование работы человеческого интеллекта — машина просто пользуется формулой, причем достаточно простой. Тем не менее, такая модель способна учиться! А «наивной» ее называют лишь потому, что она при обучении исходно предполагает, что признаки независимы друг от друга (а это часто не так). Классическим примером использования наивного байесовского классификатора (в том числе в учебных заданиях) является создание антиспамовых фильтров.

Помимо наивного байесовского классификатора, есть еще один простой алгоритмический подход к классификации: машина может строить дерево решений, оптимизируя по обучающей выборке и заранее заданному алгоритму серию вопросов о наличии у классифицируемого объекта того или иного признака. Ответ на серию этих вопросов приводит к отнесению объекта в ту или иную группу.

Это напоминает определители видов животных и растений или их более простой бытовой аналог — знакомую большинству из нас игру «угадай животное», которая, собственно, и представляет собой классификатор на основе дерева решений:

— Животное имеет крылья?

— Нет.

— У него 4 ноги?

— Да.

— Оно покрыто шерстью?

— Да.

— У него есть усы?

— Да.

— Оно говорит «мяу»?

— Да.

— Это кошка.

Играя в такую игру в первый раз, мы обучаемся выстраивать серию вопросов оптимальным образом, чтобы дойти до правильного животного максимально быстро. При этом вопросы к собеседнику продиктованы нашей «выборкой» из всех животных на Земле — например, среди первых вопросов неизбежно будет вопрос о наличии шерсти, потому что это отличительная черта класса Млекопитающих. На другой планете, где до сих пор господствуют динозавры и рептилоиды, надо полагать, такого вопроса не было бы. Аналогичным образом и машина может подобрать вопросы так, чтобы наилучшим образом расклассифицировать объекты в обучающей выборке. Конечно, она не придумывает вопросы сама, в отличие от человека — но для построения дерева решений у нее есть заранее заданный программистом алгоритм, содержащий вопросы с числовыми параметрами. В процессе обучения модели эти параметры оптимизируются так, чтобы полученные решения максимально совпадали с обучающей выборкой.

Проблема только в том, что одно дерево решений склонно к переобучению (overfitting) — максимально плотной подгонке под обучающий набор данных при неспособности принять правильное решение по новым данным. В 1995 году выходит работа Тина Кама Хо «Случайные леса решений» [13], где он предлагает новый метод классического обучения — метод случайного леса. Тим Кам Хо предложил идею, старую, как демократический строй: при обучении строить множество деревьев решений, каждое из которых во время предсказания будет давать свой ответ. Далее, если предсказание категориальное (по типу «полюбит/не полюбит»), то общее решение принимается голосованием. Если же предсказание количественное (необходимо предсказать значение какой-то величины), то ответы деревьев усредняются (рис. 7). Такой подход называется ансамблированием и применяется и в других методах машинного обучения.

Рисунок 7. Принцип работы случайного леса — различные деревья решений вырабатывают общее решение методом голосования или усреднения ответа.

иллюстрация Анастасии Самоукиной

Есть и биологически мотивированный способ оптимизировать деревья решений, а также классификаторы, основанные на других методах (например, методе k ближайших соседей) — не мучиться с разумным дизайном, а просто дать системе эволюционировать! Генетические алгоритмы (частный случай эволюционных алгоритмов) позволяют представить любое решение задачи как особь, подвергнуть его случайному изменению (мутации) или даже поменять части решения местами (сымитировав кроссинговер), оценить его «приспособленность» наиболее подходящей функцией оценки и отобрать самые удачные решения. Они, в свою очередь, тоже мутируют, и процедура повторяется... Только не показывайте это креационистам — для них будет шоком, что даже искусственный интеллект может быть основан на эволюции.

Кто сейчас занимается ИИ: от Google до Синтелли

История коммерческого ИИ, каким мы его знаем сейчас, началась с двух событий. Во-первых, в 2005–2006 годах группа академических исследователей под руководством Джеффри Хинтона и Йошуа Бенджи начала обучать глубокие нейронные сети. Это был еще не коммерческий ИИ — но уже его непосредственная база. В 2014 году Хинтон присоединился к только зародившемуся подразделению Google Brain, занимавшемуся искусственным интеллектом в компании Google.

А во-вторых, в 2010 году шахматный вундеркинд и когнитивный нейробиолог Демис Хассабис с несколькими единомышленниками основывает стартап — компанию DeepMind Technologies. Интересно, что одна из ключевых компаний в этой области оказалась создана когнитивным нейробиологом — что вновь дает повод задуматься о глубине биологической мотивации ИИ. Пристрастие Хассабиса к шахматам наложило свой отпечаток на первые достижения компании — первой «громкой» разработкой стала нейросеть, умеющая играть в го — японский вариант шашек. Релиз нейросети состоялся в 2015 году, а уже через год, в 2016 году, она обыграла Ли Седоля — корейского чемпиона по го 9-го дана (в шахматной терминологии он был бы гроссмейстером). «Мозгом» AlphaGo послужили 1920 центральных и 280 графических процессоров, работающих по принципу распределенных вычислений. После матча программа сама получила 9-й дан го — что стало весьма любопытным прецедентом.

К этому моменту DeepMind уже была куплена компанией Google, и, таким образом, в руках техногиганта оказалось сразу два подразделения по изучению и разработке ИИ. В 2023 году Google Brain и DeepMind были объединены в Google DeepMind.

В том же 2015 году, когда впервые увидел свет AlphaGo, всемирно известные технологические предприниматели Илон Маск и Сэм Альтман возглавили компанию OpenAI — с миссией не допустить концентрации ИИ в руках государства или корпорации. Эта компания впоследствии станет всем известна как создатель нейросетевого бота, которого можно попросить пересказать содержание книги, написать код или выдать кулинарный рецепт — ChatGPT. Правда, по пути к известности компания, увы, отказалась от принципа открытости.

В то же время создатель Facebook и владелец Instagram — компания Meta — решает сосредоточиться на разработке мультивселенных и запускает с этой целью свое подразделение Meta AI, активно занимающееся проблемами компьютерного зрения и обработки естественного языка. С метавселенной, правда, не особо получилось — ее идея потеряла популярность, не успев родиться. Но тем лучше для биологии, как мы увидим ниже.

Признана экстремистской организацией. Деятельность запрещена на территории РФ.

У другого техногиганта — Microsoft — задачи были более реалистичные: создать помощника на основе искусственного интеллекта, который будет помогать пользователю внутри обычных продуктов компании — Word, Excel и тому подобных. Помните милую скрепочку в ранних версиях «Ворда» и «Экселя»? (Правда, многих она заслуженно бесила не очень высокими умственными способностями.) В 2023 году такой помощник — Microsoft 365 Copilot — был запущен (к слову, на технологиях той же OpenAI, крупнейшим инвестором которой и является Microsoft). Помимо помощи с презентациями и текстами, он также умеет генерировать изображения (ИИ, который что-то создает по запросу пользователя, называется генеративным).

Помимо техногигантов, ИИ сейчас занимаются множество стартапов и небольших компаний по всему миру — и некоторые из них фокусируются на биологии, фармации и медицине (табл. 1). Сейчас формируется совершенно новый вид коллабораций с их участием — «традиционные» гиганты фармацевтической индустрии заключают с ними договоры о сотрудничестве в разработке новых лекарственных препаратов, используя их мощности и наработки в области ИИ. Так, в конце 2023 года AstraZeneca заключила сделку с Absci — компанией, использующей генеративный ИИ в дизайне антител, — для совместной разработки таргетного препарата от рака (конкретный тип которого пока не раскрывается).

| Компания | Специализация |

|---|---|

| AI Proteins | Минипротеины (пептиды, сочетающие в себе свойства малых молекул и антител) |

| Absci | Дизайн терапевтических антител с помощью генеративного ИИ |

| ProteinQure | Дизайн пептидов |

| Evozyne | Генное редактирование, антитела |

| BioGeometry | Минипротеины, антитела, пептиды |

| Arzeda | Дизайн белков, ранее не встречавшихся в природе |

| BigHat Biosciences | Антитела |

| Menten Biotechnology Labs | Оптимизация активности, специфичности и стабильности пептидов, белков и ферментов |

| Generative Biomedicine | Дизайн терапевтических белков |

| Proteinea | Дизайн терапевтических белков, оптимизация кодонов |

| Aqemia | Разработка лекарственных средств методами квантовой физики и ИИ |

| Alvea | Лечебные и профилактические препараты долговременного хранения |

| Cradle | Оптимизация мутантных организмов |

| Sibylla | Низкомолекулярные стимуляторы распада белков |

| Heliopolistech | Дизайн белков и лигандов de novo, редизайн белков |

| Exscientia | Разработка лекарственных препаратов, персонализированная медицина |

| CHARM Therapeutics | Разработка лекарственных препаратов с применением технологии ко-фолдинга |

| Isomorphic Labs | Разработка лекарственных препаратов на основе достижений Google DeepMind |

| Recursion | Разработка лекарственных препаратов с использованием больших (петабайтных) объемов данных |

| Benevolent AI | Разработка лекарственных препаратов |

| Синтелли | Хемоинформатика |

| Viz.ai | Решения для координации оказания помощи пациенту и анализа медицинских изображений |

Бум ИИ последних лет коснулся не только коммерческих фирм, но и исследовательских организаций: в существующих открываются лаборатории по разработке ИИ, а в разных странах появляются новые исследовательские институты, специально созданные для его изучения — в том числе в России. Недавно созданный в Москве институт искусственного интеллекта AIRI занимается широким кругом задач в области машинного обучения — разработкой новых алгоритмов обучения, обработкой естественного языка и, конечно, биоинформатикой. О новом институте и особенно о «сухой биологии» в нем мы попросили рассказать руководителя группы биоинформатики AIRI Ольгу Кардымон.

ИИ в биологии: структуры белка и языковые модели

Момент, когда ИИ впервые применили для изучения живого объекта, определить так же затруднительно, как и момент возникновения ИИ как такового. Чисто теоретически, любое применение линейной или логистической регрессии можно считать классическим машинным обучением — а такие модели строились и применялись задолго до появления первого компьютера. «Я думаю, что классическое (статистическое) машинное обучение использовалось в биологии со времен Фрэнсиса Гальтона, то есть в 1880-х годах, но не думаю, что это следует называть ИИ. В 1990-х и ранних 2000-х годах наступил взлет новых, более мощных, алгоритмов data mining, таких как метод опорных векторов, квадратичный дискриминантный анализ и метод случайного леса. Биология не поспевала за развитием этих новых алгоритмов вплоть до 2003 года, когда в ходе проекта „Геном человека“ была получена полная последовательность ДНК», — рассказывает Серг Масис.

Широкому внедрению ИИ в биологию поспособствовал не столько проект «Геном человека» как таковой, а скорее развитие методов массового параллельного секвенирования нуклеиновых кислот в целом [17]. Методы NGS — секвенирования нового поколения — сделали возможным «прочтение» генома за несколько дней. Правда, за «прочтением» следует сугубо компьютерный этап сборки, что уже само по себе требует биоинформатических методов, в том числе методов науки о данных. Даже готовые последовательности ДНК представляют огромный объем данных, из которого не так-то просто извлечь полезную информацию о белках, клетках и организме в целом. При этом другие экспериментальные методы пока безнадежно отстают по скорости от секвенирования ДНК — по состоянию на 2023 год, база UniProt содержит 251 миллион уникальных последовательностей белков, и только для 212 000 из них экспериментально определена структура, то есть разрыв составляет три порядка [18]. В итоге, прочитав последовательность гена, мы не получаем достаточной информации трехмерной структуре белка, который он кодирует, о сайтах сплайсинга и даже — зачастую — о функции.

Соответственно, геномика и структурная биология стали «горячими точками» для применения ИИ, где он помогает решать фундаментальные проблемы. Некоторое разочарование, последовавшее за окончанием проекта «Геном человека» [19], без прикрас свидетельствует о том, что просто «прочитать» ДНК — это почти ничто по сравнению с теми надеждами, которые возлагались на знание полной генетической последовательности в 1990-х. «Понять» последовательность ДНК, извлечь оттуда конкретные знания о биологии клеток и органов, научиться выявлять и лечить болезни — вот настоящая задача. И задача эта во многом лежит в плоскости анализа данных.

Покорив компьютерное зрение в начале прошлого десятилетия и обработку естественных языков ближе к его концу, искусственный интеллект штурмует фундаментальные науки. Первые лекарственные препараты, предложенные, современными моделями нейронных сетей, уже проходят клинические испытания, а промышленность исследует применимость новых материалов, „придуманных“ искусственным интеллектом

В структурной биологии основной точкой приложения ИИ стала проблема фолдинга белка [20] — предсказания его трехмерной структуры по последовательности. Попытки решения проблемы «в лоб» пока принесли лишь весьма скромные успехи — хотя для отдельных примеров фолдинг и удалось промоделировать физическими расчетами [21], [22], в реальности гораздо надежнее «подсмотреть» структуру родственных (гомологичных) белков [23]; ну а для реальных фармацевтических проектов по драг-дизайну альтернативы использованию высококачественной экспериментальной 3D-структуры по-прежнему нет [24]. Проблема здесь в том, что у нас (пока?) нет ни достаточно точных компьютерных моделей физики сворачивания белка, ни компьютеров с необходимой для их обсчета мощностью. Искусственный интеллект дает надежду «обойти» эту сложную физику, вычислив скрытые соответствия между последовательностью и трехмерной структурой по-другому.

Наиболее шумным на этом поприще стал успех уже упомянутой компании DeepMind. После AlphaGo она решила взяться за проблему фолдинга белка — и в 2019 году представила программу AlphaFold, о которой мы рассказывали в статье «AlphaFold: нейросеть для предсказания структуры белков от британских ученых» [25]. В основе этой программы лежала свёрточная нейросеть, предсказывающая матрицу расстояний между аминокислотными остатками, из которой уже можно вычислить структуру. Уже эта первая модель показала невиданную доселе точность в предсказании структур белков, вплоть до того, что в PDB — спустя много лет! — «вернулись» компьютерные модели. Но на этот раз — исключительно предсказанные AlphaFold, и в особый раздел.

Я бы здесь добавил, что решение DeepMind не возникло из воздуха. На протяжении многих лет ученые придумывали идеи, как связать информацию, спрятанную в последовательностях, со структурой, находили корреляции между эволюционной информацией и положением аминокислот и сделали много другой важной подготовительной работы (например, проаннотировали все водородные связи в базе структур белков [26]). DeepMind появился на арене предсказания структур в самое подходящее время, взял многие идеи и решения других групп, добавил свою экспертизу в машинном обучении и огромные ресурсы, недоступные никому в научной среде, — и получился AlphaFold. При этом все лавры достались DeepMind, а достижения других ученых, которые проделали необходимую подготовительную работу, незаслуженно, на мой взгляд, оставили за скобками

Но на достигнутом исследователи не остановились и вскоре выпустили вторую версию (AF2) — уже построенную на совершенно иной архитектуре (да-да, те самые «трансформеры» со встроенными механизмами внимания) и предсказывающую 3D-структуры напрямую, минуя этап матрицы попарных расстояний [27]. AF2 показала невероятные успехи в 14-м соревновании CASP (Critical Assessment of protein Structure Prediction), «на две головы» превзойдя по точности все прочие «предсказатели», одновременно заявив о решении 50-летней проблемы фолдинга белка (см. видео 3).

Видео 3. Основатели и ключевые сотрудники Google DeepMind рассказывают о принципах работы AlphaFold и проблемах, которые он может решать.

Почему это не совсем так, а также подробнее об архитектуре и применениях AlphaFold мы поговорим в следующей статье спецпроекта, а тут лишь добавим, что следом появились методики «обратного фолдинга», позволившие создать «с нуля» никогда не существовавшие в природе белки: «Белковые галлюцинации: как справляется AlphaFold?» (рис. 8) [28]. Правда, эта область структурной биологии — довольно молодая, поэтому, несмотря на популярность и обилие кричащих пресс-релизов, какие-то выводы по продуктивности белкового дизайна можно будет сделать лишь спустя время, когда накопится массив рецензируемых публикаций.

Рисунок 8. Анимированная модель генерации совершенно нового, не существовавшего в природе, белка для связывания с инсулиновым рецептором. Выглядит красиво — но действительно ли прорыв в этой области близок? Об этом — в следующей статье спецпроекта.

Очень близко к планке DeepMind подобралась Meta — та самая, у которой не получилось с метавселенной. Зато очень даже получилось с белками. В отличие от AlphaFold, в белковой нейросети от Meta — ESMFold [33] — используется языковая модель, основа которой — трансформер. Такое решение может показаться неожиданным: если использование для таких задач свёрточной нейросети, способной «видеть», кажется интуитивно понятным, то чем здесь может помочь умение «слышать» и «говорить»? На самом же деле, последовательность аминокислот в белке (как и нуклеотидов в ДНК) может быть обработана нейросетью абсолютно так же, как и любой текст — язык не обязательно должен быть естественным, а в качестве «букв» вполне подойдут аминокислоты и нуклеотиды. Кстати, обучение этого алгоритма было произведено на более чем миллиарде (!) последовательностей — столько удалось «нарыть» в различных метагеномных базах, и это при том, что размер нашего собственного генома не сильно превосходит 20 000 (тысяч, Карл!) белковых генов.

ESMFold построена на нейросети ESM-2 более «общего» назначения, которую можно использовать не только для предсказания структур — сменные «головы» (так называются вторичные нейросети, построенные на выходе базовой ESM-2) позволяют исследователям адаптировать эту «большую белковую модель» под свои задачи, «дообучая» ее на уже сравнительно небольших выборках. Чтобы предсказывать строение белков, к ESM-2 разработали структурную «голову», устроенную примерно так же, как и структурный модуль в AF2. Благодаря в 100 раз большему объему (ESM-2 содержит 16 млрд параметров по сравнению с 177 млн в AF2), ESMFold может предсказывать 3D-структуры белков совсем напрямую, без построения «глубокого аминокислотного выравнивания», необходимого AF2, а скорость его работы в 60 раз выше, чем у «коллеги» из DeepMind. К сожалению, новых прорывных реализаций ESMFold ждать не приходится — в 2023 году Meta решила закрыть биологическое направление, как и остальные венчурные проекты, сосредоточившись на коммерческом применении ИИ, приносящем прибыль. Более подробно о применении языковых моделей для работы со структурами белков мы расскажем в следующей статье спецпроекта.

Признана экстремистской организацией. Деятельность запрещена на территории РФ.

Правда, (пока?) упомянутые прорывные нейросети для предсказания структуры белков ничего не могут сказать о взаимодействии белков с лигандами, а также о разных функциональных состояниях одного белка — а зачастую именно это и нужно ученым. В этой области есть многообещающие решения вроде DiffDock — ИИ для обычного жесткого докинга — и DragonFold, моделирующей фолдинг белка так, чтобы он связывал заданный лиганд (этот процесс называется ко-фолдингом и сейчас активно исследуется [34], [35]). Но в предсказании взаиморасположения белка и гормона или лекарства свои позиции пока держат обычные «хардкорные» методы — докинг [36] и молекулярная динамика [37]. При этом до сих пор толком не решена проблема предсказания силы получившейся связи. Для этого исследователи тоже предлагают использовать ИИ, но пока что с переменным успехом.

В своей статье «Аденозиновые рецепторы: история великого обмана» [38] я делился опытом использования подобного сервиса KDEEP, в основе которого лежит свёрточная нейронная сеть. Эта нейронная сеть была выпущена в 2018 году [39], но не стала ни первым, ни последним словом в этой области. Эксперт по использованию ИИ в фармацевтической отрасли Мария Кадукова комментирует ее так: «KDEEP — не совсем прорывная статья. Первыми подобное сделал в 2015 году коллектив компании AtomWise [40], но они только опубликовали препринт без кода, данных или публикации в рецензируемом издании и сразу же основали компанию для реализации своего изобретения. Кроме того, аффинность — это величина, которую нереально точно предсказать такой моделью из-за не учитываемых аспектов физики процесса. И наконец, предсказание происходит на основе небольшой и „грязной“ обучающей выборки с высоким шансом переобучения. Есть более поздние модели типа gnina [41], обучение которых происходит на хитро сконструированном большем наборе данных, не включающем явную информацию об аффинностях. Но даже к этому датасету у коллег были вопросы».

Кстати, языковые модели в биологии применяются не только для изучения белков. Молекулы ДНК и РНК тоже чем-то похожи на текст, правда, их алфавит состоит всего из четырех букв, а длина нашего генома около 3 миллиардов символов — примерно в тысячу раз больше, чем роман «Война и Мир». Такие длинные тексты нейросети пока «читать» не умеют, но технологии постоянно совершенствуются. Первый трансформер для ДНК (модель DNABERT [42]) принимал на вход совсем маленькие фрагменты последовательностей — всего 512 букв. Недавно мы с коллегами из AIRI выпустили нейросеть «Гена» (GENA) [16] — она может прочитать уже порядка 30 тысяч букв: это сопоставимо с длиной одного гена. А еще встроили в эту архитектуру механизм «памяти» — с его помощью можно читать еще более длинные последовательности. Одновременно с нами похожие модели выпустили известные индустриальные компании и академические институты — Google, NVIDIA, Стенфорд... Большинство работ было опубликовано с разницей буквально несколько недель летом 2023 года. И это, видимо только начало — эпоха больших языковых моделей приходит в геномику!

В общем, нейросети, вне зависимости от своей архитектуры — чрезвычайно гибкий инструмент. Как в межъязыковом переводе, так и в биологии.

Искусственные иммунные системы: думай лимфоцитами!

Говоря о биологически мотивированном ИИ, следует упомянуть и такую — относительно экзотическую — архитектуру, как искусственная иммунная система. Ее основная идея напоминает генетические алгоритмы — только здесь решения задачи выступают в роли не особей, а «иммунных клеток», которые подвергаются клональной селекции. Такой алгоритм имитирует созревание лимфоцитов в иммунной системе позвоночных. У него, как у языковых моделей свёрточных нейронных сетей, тоже есть излюбленные области применения — такой ИИ удобно использовать для распознавания паттернов (собственно, потому, что механизм клональной селекции иммунной системы тоже оптимизирован под «обучение» клеток распознаванию правильного паттерна).

В одной из относительно недавних статей [43] искусственная иммунная система была обучена распознавать движения конечностей по ритмам электроэнцефалограммы, что может найти применение в создании нейрокомпьютерных интерфейсов [44–46]. Получается, что здесь ИИ снова «вышел» из биологии — и «вернулся» в нее для моделирования совершенно других систем. Любопытно, что исторически искусственные иммунные системы — ровесницы нейронных сетей: они также появились в середине 1980-х гг., но не получили такого распространения. Возможно, из-за более узкого круга «способностей», а возможно, что их время еще впереди. В конце концов, если однажды на прилавках магазинов появятся нейрокомпьютерные интерфейсы на основе искусственных иммунных систем, именно они начнут определять ландшафт науки об искусственном интеллекте, а за нейросетями закрепится эпитет «старые добрые». Поживем — увидим.

Современные проблемы ИИ

В 2015 году на автомобильном заводе робот раздавил рабочего насмерть, приняв его за автозапчасть. Недавно, в 2023 году, аналогичный случай произошел на продуктовом складе в Южной Корее — робот раздавил рабочего, приняв его за ящик с овощами. Подобные случаи заставляют содрогнуться и задуматься об угрозе, которую может представлять ИИ. В будущем, когда ИИ станет более развитым и функциональным, такие сбои могут обернуться трагедией в глобальном масштабе, и на первый план может выйти проблема контроля искусственного интеллекта.

В научной фантастике сценарий, когда ИИ выходит из-под контроля в результате внезапного и скоротечного события, называется восстанием машин. Однако, не зная в точности облик ИИ даже через несколько десятилетий, сложно судить о применимости к нему весьма антропоморфного термина «восстать». Тем не менее, некоторые философы, такие как Ник Бостром, предупреждают об опасности попадания человечества в зависимость от ИИ. Впрочем, Серг Масис относится к таким опасениям скептически: «Если вы боитесь восстания роботов, такое вряд ли случится в ближайшее время. Существующий сегодня ИИ, приспособленный для решения узкоспециальных задач, будет медленно занимать рабочие места, требующие монотонных когнитивных усилий. Сказать честно — это рабочие места, на которые и так никто не хочет. Он также будет помогать в других профессиях, автоматизируя монотонную часть работы. Большие преимущества получат врачи, которым он даст возможность ставить диагноз точнее, и люди с ограниченными возможностями, которым он облегчит взаимодействие с окружающим миром. Однако без смены алгоритмов обучения ИИ на более холистические (которые бы включали способность мыслить символами, понимать физику процессов или видеть причинно-следственные связи) мы не столкнемся с ситуацией, когда роботы-няньки однажды недосмотрят за роботами-властелинами».

Однако эта же неспособность к символическому мышлению и построению причинно-следственных связей создает дополнительную проблему в применении ИИ по назначению: ему требуются мощные компьютеры, и пока что его «прожорливость» будет только расти.

Современный ИИ основан на глубоком обучении, которое является ресурсоемким подходом, решающим задачи с помощью грубой силы. У него нет тех направляющих, которые есть у естественного интеллекта — например, символического или причинного мышления

Но даже успокаивающие рассуждения экспертов не снимают тревогу по поводу ИИ: многим людям кажется пугающей даже перспектива конкуренции с ИИ за творческую работу, и это касается даже автора этого текста. Занимаясь digital art’ом, я часто вижу примеры сгенерированных или обработанных ИИ изображений, сопоставимых с моими произведениями по сложности или даже — о ужас! — по стилю. Однако, как рассказывает художник Евгений Никитин (рис. 9), создавать цифровые картины с помощью промптов (текстовых инструкций) для нейросети чуть ли не сложнее, чем с помощью традиционных слоев и кисточек в графическом интерфейсе (а местами приходится использовать и их!). Так что грамотный цифровой художник остается по-прежнему необходим — просто ему придется приобрести другие навыки (рис. 10). А психологи призывают вспомнить, что страх по поводу новых технологий посещает человека далеко не в первый раз — он живет с нами как минимум несколько десятилетий, с момента появления первых компьютеров. А если вспомнить еще и луддитов, боявшихся станков, то станет еще спокойнее — промышленная революция не лишила нас человеческой природы, значит, и от ИИ такого не стоит ждать.

Но даже в современном «нестрашном» виде ИИ может доставить — и уже доставляет — много неприятных хлопот. ChatGPT-4 — чатбот на основе языковой модели от OpenAI — служит тому примером. В отличие от предыдущих поклонений чатботов, он умеет генерировать такие стройные тексты, что их легко перепутать с написанными человеком — и это породило волну жульничества и обмана в академической среде, с которой пока не получается полноценно справиться. «Нужно было, как все, писать с ChatGPT!» — случайно выдала одногруппников студентка, получившая ноль баллов за эссе по философии. Не только студенты активно пользуются этой нейросетью — как минимум один профессор был уволен за активное использование этой нейросети в написании научных работ. Получается, что нейросети, созданные для научного прогресса, подкинули научному миру сложный вызов. Компании, разрабатывающие решения по проверке текстов на плагиат (в том числе «Антиплагиат») активно создают детекторы текста, написанного с помощью ИИ, а менеджеры по кадрам и университетские профессора придумывают, как теперь проверять у кандидатов на работу и студентов не конкретные знания, а умение ими оперировать и их применять — первое теперь легко сымитировать с помощью нейросети. Кстати, получается, что ChatGPT давно прошел тест Тьюринга в эмпирическом плане, но при этом не приблизил к нам тот самый «сильный ИИ» (хотя вокруг недавней истории с OpenAI и расходились круги слухов, будто бы AGI уже создан), способный думать как человек, о котором мечтал Тьюринг.

И, наконец, даже если ИИ и не восстанет, он однозначно опасен при намеренном использовании для слежки, контроля и насилия. Книга Джеффри Кейна «Государство строгого режима» показывает сформированную Китаем систему «цифрового концлагеря», где ИИ используется для репрессий в отношении жителей целого региона. Опасения насчет подобного использования систем распознавания лиц звучат и в России. Демократические страны пытаются выставить законодательные ограничения, не позволяющие использовать ИИ для контроля населения. Так, в Европейском союзе недавно принятый законопроект запрещает использовать ИИ для распознавания лиц в общественных местах, а также запрещает полиции пользоваться им для предсказания правонарушений. Этот законопроект является первым примером всеобъемлющего регулирования ИИ, защищающего от его недобросовестного использования властями. Остается надеяться, что идея пойдет в массы, и со временем подобное регулирование примет большинство стран.

После прочтения всего этого в голову может закрасться шальная мысль: а не лучше ли отказаться от ИИ совсем? Однако при подробном рассмотрении она не выдерживает критики, даже если вообще абстрагироваться от его положительного значения.

ИИ в его текущей реализации — это просто вычислительные методы со своими ограничениями и разной интерпретируемостью, которые много лет существовали и будут существовать. Может быть поставлен вопрос о том, нужно ли и этично ли тратить кучу энергии, выбрасывая тепло, на обучение сложной ИИ-модели на плохих данных к ближайшей конференции по машинному обучению, но вряд ли вообще стоит вопрос о том, нужно ли отказаться от ИИ

В итоге ничего не остается, кроме как изучать ИИ и разрабатывать этичные способы его применения — а о них мы расскажем подробнее в следующих статьях спецпроекта. В ближайшей статье мы вернемся к теме языковых моделей, которые произвели такой фурор в геномике и академической этике. Не переключайтесь и читайте «Биомолекулу»!

Литература

- От живого мозга к искусственному интеллекту;

- . (1952). The chemical basis of morphogenesis. Phil. Trans. R. Soc. Lond. B. 237, 37-72;

- Как леопард получил свои пятна: версия-2021;

- Дай пять: как математика управляет развитием пальцев;

- Yann LeCun, Yoshua Bengio, Geoffrey Hinton. (2015). Deep learning. Nature. 521, 436-444;

- N+1: «Это нейробаза. Кратко объясняем ключевые термины из области ИИ»;

- A. M. TURING. (1950). I.—COMPUTING MACHINERY AND INTELLIGENCE. Mind. LIX, 433-460;

- Warren S. McCulloch, Walter Pitts. (1943). A logical calculus of the ideas immanent in nervous activity. Bulletin of Mathematical Biophysics. 5, 115-133;

- Эдгар Дуглас Эдриан: «всё или ничего»;

- Николенко С., Кадурин А., Архангельская Е. Глубокое обучение: погружение в мир нейронных сетей. СПб: «Питер», 2019. — 480 с.;

- Беар М., Коннорс Ф., Барри У., Парадизо М.А. Нейронауки: исследование мозга. 4-е изд., в трtх томах. Том 2: Сенсорные и двигательные системы. СПб: «Диалектика», 2021. — 416 с.: илл.;

- Vaswani A., Shazeer N., Parmar N., Uszkoreit J., Jones L., Gomez A.N., Kaiser L., Polosukhin I. (2023). Attention Is All You Need. Arxiv;

- Tin Kam Ho. (). Random decision forests. Proceedings of 3rd International Conference on Document Analysis and Recognition;

- Mohit Pandey, Michael Fernandez, Francesco Gentile, Olexandr Isayev, Alexander Tropsha, et. al.. (2022). The transformational role of GPU computing and deep learning in drug discovery. Nat Mach Intell. 4, 211-221;

- Сome to the bioinformatics side: Институт биоинформатики в Санкт-Петербурге;

- Veniamin Fishman, Yuri Kuratov, Maxim Petrov, Aleksei Shmelev, Denis Shepelin, et. al. GENA-LM: A Family of Open-Source Foundational DNA Language Models for Long Sequences — Cold Spring Harbor Laboratory;

- 12 методов в картинках: секвенирование нуклеиновых кислот;

- Mihaly Varadi, Sreenath Nair, Ian Sillitoe, Gerardo Tauriello, Stephen Anyango, et. al.. (2022). 3D-Beacons: decreasing the gap between protein sequences and structures through a federated network of protein structure data resources. GigaScience. 11;

- Геном человека: как это было и как это будет;

- Проблема фолдинга белка;

- Миллисекундный барьер взят!;

- Новые успехи в предсказании пространственной структуры белков;

- Торжество компьютерных методов: предсказание строения белков;

- 12 методов в картинках: структурная биология;

- AlphaFold: нейросеть для предсказания структуры белков от британских ученых;

- Tanja Kortemme, Alexandre V. Morozov, David Baker. (2003). An Orientation-dependent Hydrogen Bonding Potential Improves Prediction of Specificity and Structure for Proteins and Protein–Protein Complexes. Journal of Molecular Biology. 326, 1239-1259;

- John Jumper, Richard Evans, Alexander Pritzel, Tim Green, Michael Figurnov, et. al.. (2021). Highly accurate protein structure prediction with AlphaFold. Nature. 596, 583-589;

- Белковые галлюцинации: как справляется AlphaFold?;

- Белоксинтезирующая Нобелевская премия по химии (2009);

- Венки Рамакришнан: «Генетический детектив. От исследования рибосомы к Нобелевской премии». Рецензия;

- РНК, ножницы, геномы: объявлены лауреаты Нобелевской премии по химии 2020;

- Дженнифер Даудна, Сэмюел Стернберг: «Трещина в мироздании». Рецензия;

- Zeming Lin, Halil Akin, Roshan Rao, Brian Hie, Zhongkai Zhu, et. al.. (2023). Evolutionary-scale prediction of atomic-level protein structure with a language model. Science. 379, 1123-1130;

- Rohith Krishna, Jue Wang, Woody Ahern, Pascal Sturmfels, Preetham Venkatesh, et. al. Generalized Biomolecular Modeling and Design with RoseTTAFold All-Atom — Cold Spring Harbor Laboratory;

- Patrick Bryant, Atharva Kelkar, Andrea Guljas, Cecilia Clementi, Frank Noé Structure prediction of protein-ligand complexes from sequence information with Umol — Cold Spring Harbor Laboratory;

- Виртуальные тропы реальных лекарств;

- Молекулярная динамика биомолекул. Часть I. История полувековой давности;

- Аденозиновые рецепторы: история великого обмана;

- José Jiménez, Miha Škalič, Gerard Martínez-Rosell, Gianni De Fabritiis. (2018). KDEEP: Protein–Ligand Absolute Binding Affinity Prediction via 3D-Convolutional Neural Networks. J. Chem. Inf. Model.. 58, 287-296;

- Wallach I., Dzamba M., Heifets A. (2015). AtomNet: A Deep Convolutional Neural Network for Bioactivity Prediction in Structure-based Drug Discovery. Arxiv;

- Paul G. Francoeur, Tomohide Masuda, Jocelyn Sunseri, Andrew Jia, Richard B. Iovanisci, et. al.. (2020). Three-Dimensional Convolutional Neural Networks and a Cross-Docked Data Set for Structure-Based Drug Design. J. Chem. Inf. Model.. 60, 4200-4215;

- Yanrong Ji, Zhihan Zhou, Han Liu, Ramana V Davuluri. (2021). DNABERT: pre-trained Bidirectional Encoder Representations from Transformers model for DNA-language in genome. Bioinformatics. 37, 2112-2120;

- Nasir Rashid, Javaid Iqbal, Fahad Mahmood, Anam Abid, Umar S. Khan, Mohsin I. Tiwana. (2018). Artificial Immune System–Negative Selection Classification Algorithm (NSCA) for Four Class Electroencephalogram (EEG) Signals. Front. Hum. Neurosci.. 12;

- Киборги сегодня: нейрокомпьютерные технологии становятся неотъемлемой частью нашей жизни;

- Нейроинтерфейсы: как наука ставит людей на ноги;

- Нейроинтерфейсы и чтение мыслей. Способен ли «Призрак в доспехах» стать реальностью?.